Pendant que les dispositifs de police prédictive (comme PredPol) commencent à être interdits ou abandonnés aux États-Unis, la police française et plusieurs collectivités continuent à acheter et utiliser des équivalents français, à l’image de « Map Révélation » proposé par l’entreprise angevine « Sûreté Globale ». Cela au détriment des risques de discriminations qu’impliquent ces logiciels de surveillance, et en l’absence même de toute preuve de leur intérêt.

Comme pour la reconnaissance faciale, les logiciels de police prédictive commencent à subir plusieurs interdictions ou abandons aux États-Unis. La promesse de prédire, à l’aide d’un algorithme, les futurs crimes ou délits à partir des données issues des force de police n’a évidemment pas été tenue. À Los Angeles, la police vient ainsi de décider de ne plus utiliser PredPol (un des logiciels de police prédictive les plus médiatisés). Si c’est l’argument budgétaire qui est avancé, il ne fait pas de doute que c’est bien le travail des groupes militants anti-surveillance qui a fini par payer.

Même chose pour plusieurs autres villes aux États-Unis ou en Angleterre. Plus loin encore, la ville de Santa Cruz a officiellement banni en juin dernier les techniques de police prédictive, évoquant les effets discriminatoires que ces logiciels perpétuent.

Biais discriminatoires et disparition de l’humain

C’est en effet la critique la plus récurrente qui est faite à ce type de dispositifs : les quartiers les plus pauvres souffrant d’une présence policière excessive se retrouvent souvent sur-représentés dans les statistiques policières. Les algorithmes, qui se fondent sur ces données passées, vont donc les désigner comme lieux où la surveillance doit être renforcée, et donc perpétuer les biais existants. Ainsi, comme le rappelle Olivier Ertzscheid, une donnée n’étant jamais brute mais au contraire le fruit d’une construction sociale, le dispositif de police prédictive « installe un système de valeurs et le perpétue ». Les biais racistes dans les méthodes de collecte de données de la police se retrouvent à la fois blanchis par la soi-disant objectivité de la machine et décuplés par un effet de renforcement (plus de données sur les quartiers en proie à la sur-policiarisation conduit à prédire d’avantage d’acte de délinquance dans ces quartier, et donc à plus de patrouilles, qui génèrent à leur tour plus de données, et ainsi de suite).

Ces systèmes de police prédictive ont également un point commun avec d’autres dispositifs de la Technopolice, à savoir une approche gestionnaire de la sécurité publique, où l’on va chercher à supprimer ou ajuster les conséquences d’un phénomène social plutôt que s’interroger sur ses causes profondes et rechercher des solutions de long terme. Le risque c’est aussi de déléguer cette gestion à l’algorithme : ne plus en faire le résultat d’une décision humaine, mais la simple application de la décision prise par la machine. Jusqu’à quand et à quel point cette décision sera remise en question et soumise à discussion, et non pas seulement prise comme une vérité absolue ?

Un dispositif dangereux et à l’efficacité douteuse

La dernière critique couramment adressée à ces dispositifs, c’est qu’ils n’ont pas fait la preuve de leur intérêt. Tout au plus permettent-ils de visualiser des données dont la police disposait déjà. Il s’avère aussi bien compliqué d’évaluer l’efficacité de ces logiciels : si l’évènement prédit par la machine a lieu, l’outil sera présenté comme efficace. Mais si l’évènement n’a pas lieu, l’outil pourra aussi être considéré comme efficace en ce qu’un patrouille envoyée sur place aurait dissuadé les personnes d’agir…

Pourtant, la police continue d’acheter et d’utiliser ce type de logiciel. Peut-être parce qu’ils cèdent au marketing intensif des industriels sécuritaires. Ou peut être ont-ils également peur de ne pas être assez modernes, aveuglés par la croyance dans le fait que s’équiper des dernières technologies de contrôle social est une fin en soi, qu’importe leur impact sur nos libertés, leur coût, ou même leur intérêt. Ces deux logiques — pressions industrielles et solutionnisme technologique — semblent en effet expliquer la propagation de la police prédictive à travers la France.

La France, bonne cliente des logiciels de police prédictive

C’est en travaillant sur les documents reçus à propos de l’ « Observatoire de la tranquillité publique » à Montpellier (ils sont également disponibles à la fin de cet article) que nous sommes tombés sur la convention conclue entre la ville et l’entreprise Sûreté Globale. Son but : l’acquisition d’un « logiciel d’analyse statistique et cartographique de la délinquance ». Il s’agit ici de « Map Revelation ». Si l’on en croit le site, le logiciel « fournit des analyses prédictives, graphiques et géographiques, de semis de points » composés, selon les clients, de « faits de délinquance, incidents, » mais aussi, dans le commerce, de « ventes, SAV, événements…), […] révèle les lieux et les moments importants, et prédit les occurrences ». Et selon une autre source : « Ce logiciel interactif, associé à un système informatique géographique, donne la possibilité de cartographier précisément les faits et d’agir en conséquence. Équipées d’un système prédictif, les patrouilles de police sont ajustées en fonction des besoins et la stratégie en matière de police de proximité se voit améliorée ». Un PredPol à la française donc.

Ses créateurs se vantent d’ailleurs d’un taux de prédiction particulièrement élevé (et qui apparaît difficilement vérifiable) : des « scores » qui tourneraient autour de 80% de fiabilité « sur le où, et le quand », particulièrement sur les cambriolages où « il devient possible de prévoir où et quand dans une journée, ils vont se produire ». Des chiffres et des affirmations en contradiction totale avec les observations qui ont conduit aux États-Unis à l’abandon des mêmes logiciels.

Pourtant, les clients en France sont très nombreux : Montpellier donc, mais aussi l’agglomération Hérault Méditerranée (qui a investi 24.000 euros dans ce système en 2019), ou Lyon, Lille, Montauban, Villeurbanne, Angers, Colombes… Mais pas seulement des collectivités : la Gendarmerie nationale (qui semble l’utiliser depuis 2015 pour « prédire les zones à risque de délits fréquents (cambriolages, vols, trafics, viols) pour mieux orienter ses patrouilles », la préfecture de police de Paris, la police aux frontières…

Preuve que la police prédictive, comme la Technopolice en générale d’ailleurs, n’est pas une particularité américaine ou chinoise et que les autorités françaises sont également friandes de ces nouveaux outils de surveillance. Preuve aussi de la collusion public-privée associée à ce genre de projets : Christophe Courtois, président de Sûreté Globale, a été pendant 6 ans conseiller de défense du préfet de Maine-et-Loire (et parmi les « conseillers » de l’entreprise se trouvent aussi un ancien préfet et un colonel de l’armée…)

Multiplier les données aspirées

Comme ces logiciels ont besoin de données sur lesquelles s’appuyer, les collectivités qui mettent en place « Map Revelation » concluent également des conventions avec la police nationale pour s’échanger leurs bases de données et croiser leurs informations.

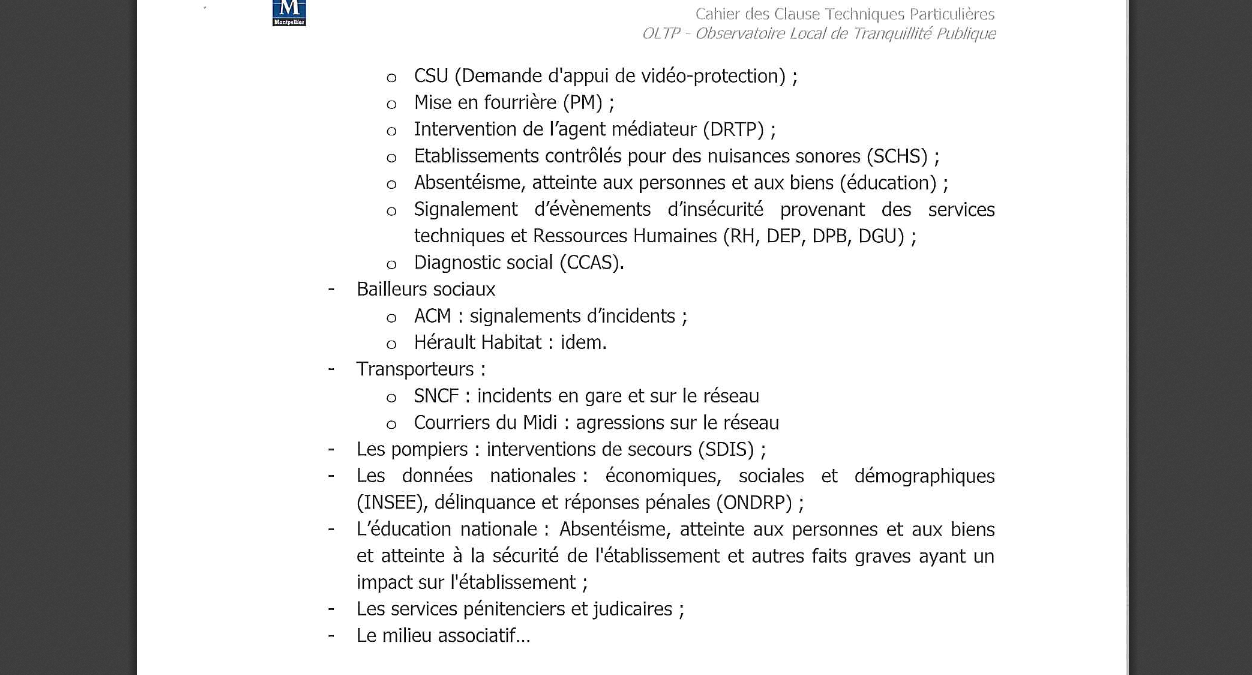

C’est le cas à Montpellier où pour nourrir le logiciel, la ville récupère de la police nationale plusieurs jeux de données (vols de véhicule, cambriolages, vols à main armée…). En échange, la ville communique à la police des données dont l’État ne disposait pas (« enquête de victimisation, interventions des services sociaux, remontées des bailleurs sociaux… »). D’ailleurs, il est particulièrement inquiétant de voir les données que Montpellier veut intégrer dans le logiciel de police prédictive et qu’il renseigne dans un des documents du marché conclu avec Sécurité Globale : « mise en fourrière », « absentéisme, atteinte aux personnes et aux biens (éducation) », « signalement d’évènements d’insécurité provenant des services techniques et ressources humaines », « milieu associatif »… En quoi l’absentéisme scolaire ou les données du « milieu associatif » ont un lien avec un logiciel dit d’observatoire de la « délinquance » ?

On retrouve en fait ici les mêmes logiques que dans l’ « Observatoire Big Data de la tranquillité publique » expérimenté depuis 2018 à Marseille : celui de capter un maximum de données, de les cartographier, de les analyser et de les passer au filtre d’un algorithme pour en tirer des décisions en matière de sécurité publique et de gestion de la ville. On retrouve d’ailleurs à Marseille une même convention d’échange de données entre ville et la police nationale pour « visualiser sur une carte l’ensemble des évènements et faits impactant l’espace public » — notamment les « manifestations revendicatives », et « identifier les zones de tension ».

Cette logique de captation et d’échanges de données entre les collectivités locales et l’État à des fins de statistiques Big Data et de police prédictive semble malheureusement s’étendre en France, et ce dans l’opacité la plus totale. La CNIL ne trouve rien à y redire, alors même que ces projets ne s’accompagnent d’aucune étude d’impact, et ne disposent d’aucune base légale satisfaisante. Surtout, leur dangerosité en terme de libertés publiques est complètement passée sous silence par les autorités. Comme pour la reconnaissance faciale et autres formes de vidéosurveillance automatisée, il nous appartient de nous mobiliser pour nous opposer à ces déploiements et obtenir leur interdiction, à l’image des victoires récentes obtenues par les collectifs étasuniens. Pour rejoindre notre campagne dédiée, rendez-vous sur le forum Technopolice.

Documents communiqués par la ville de Montpellier

Conseil Municipal de la ville de Montpellier du 15 décembre 2016

Procès verbal de vérification d’aptitude pour Sûreté Globale

Document du marché public passé entre Montpellier et Sûreté Globale

Convention entre la police nationale et la ville de Montpellier